Neu: Flexible Service-Kontingente für die Myra WAF. Jetzt mehr erfahren!

Home>

Web Scraping

02

Wie funktioniert Web Scraping?

Beim Web Scraping kommen unterschiedliche Technologien und Tools zum Einsatz:

Manuelles Scraping

Tatsächlich werden sowohl Inhalte als auch Quellcode-Abschnitte von Websites gelegentlich von Hand kopiert. Auf diese Methode greifen Internet-Kriminelle insbesondere dann zurück, wenn Bots und weitere Scraping-Programme durch die robots.txt-Datei blockiert sind.

Software-Tools

Web-Scraping-Tools wie Scraper API, ScrapeSimple oder Octoparse ermöglichen das Erstellen von Web Scrapern auch mit geringen oder keinen Programmierkenntnissen. Entwickler nutzen diese Tools auch als Basis, um eigene Scraping-Lösungen zu entwickeln.

Text Pattern Matching

Das automatisierte Abgleichen und Auslesen von Informationen aus Webseiten kann auch mit Hilfe von Befehlen in Programmiersprachen wie Perl oder Python erfolgen.

HTTP-Manipulation

Mittels HTTP-Request lassen sich Inhalte von statischen oder auch dynamischen Websites kopieren.

Data Mining

Web Scraping ist ebenfalls per Data Mining möglich. Hierzu setzen Webentwickler auf eine Analyse von Templates und Skripten, in welchen die Inhalte einer Website eingebettet sind. Dabei identifizieren sie den gesuchten Content und spielen diesen über einen sogenannten Wrapper auf der eigenen Seite aus.

HTML-Parser

Die aus Browsern bekannten HTML-Parser dienen beim Web Scraping zum Auslesen und Umwandeln des gesuchten Contents.

Auslesen von Mikroformaten

Mikroformate sind häufig Bestandteil von Websites. Sie enthalten beispielsweise Metadaten oder semantische Anmerkungen. Das Auslesen dieser Daten ermöglicht Rückschlüsse auf die Lokalisierung spezieller Data Snippets.

03

Nutzung und Einsatzgebiete

Web Scraping findet in vielen verschiedenen Bereichen Anwendung. Stets dient es der Datenextraktion – oftmals zu völlig legitimen Zwecken, doch auch die missbräuchliche Verwendung ist Usus.

Webcrawler von Suchmaschinen

Die Indexierung von Websites ist die Basis für die Funktionsweise von Suchmaschinen wie Google und Bing. Nur durch den Einsatz von Webcrawlern, welche URLs analysieren und indexieren, ist die Sortierung sowie Darstellung von Suchergebnissen überhaupt möglich. Webcrawler gehören zu den sogenannten Bots, es handelt sich also um Programme, die automatisch definierte und sich wiederholende Aufgaben erledigen.

Webservice-Ersatz

Screen Scraper können als Ersatz für Webservices verwendet werden. Dies ist insbesondere für Unternehmen interessant, welche auf einer Website ihren Kunden bestimmte Auswertungsdaten zur Verfügung stellen wollen. Einen Webservice dafür zu nutzen, zieht jedoch hohe Kosten nach sich. Daher sind Screen Scraper, welche die Daten extrahieren, die kostengünstigere Option.

Remixing

Beim Remixing bzw. Mashup werden die Inhalte verschiedener Webdienste miteinander verbunden. Das Ergebnis ist ein neuer Dienst. Oft geschieht das Remixing über Schnittstellen, doch in dem Fall, dass keine solchen APIs vorhanden sind, wird hier ebenfalls die Technik des Screen Scraping angewandt.

Missbrauch

Die missbräuchliche Verwendung von Web Scraping oder auch Web Harvesting kann unterschiedliche Zielsetzungen haben:

Preis-Grabbing: Eine besondere Form des Web-Scrapings stellt das Preis-Grabbing dar: Dabei liest ein Anbieter mithilfe von Bots die Produktpreise der Konkurrenten aus, um diese gezielt zu unterbieten und damit Kunden zu gewinnen. Durch die große Preistransparenz im Internet wandern Kunden schnell zum nächstgünstigen Anbieter – der Preisdruck steigt.

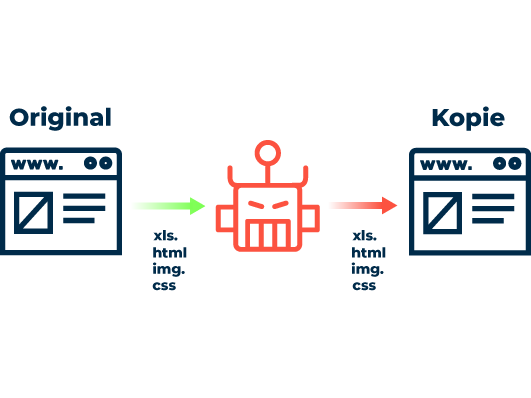

Content- / Product Grabbing: Statt Preisen oder Preisgefügen haben es die Bots beim sogenannten Content-Grabbing auf die Inhalte der Webseite abgesehen. Aufwändige gestaltete Produktseiten in Online-Shops kopieren Angreifer dabei originalgetreu und nutzen den teuer erstellten Content für die eigenen E-Commerce-Portale. Ebenfalls beliebte Ziele für Content-Grabbing stellen Online-Marktplätze, Jobbörsen oder Kleinanzeigen dar.

Verlängerung der Ladezeiten: Web-Scraping verschwendet wertvolle Serverkapazitäten: Bots in großer Anzahl aktualisieren ständig Produktseiten auf der Suche nach neuen Preisangaben. Dies verlängert – insbesondere bei Hochlastzeiten – die Ladezeiten für herkömmliche Nutzer. Dauert das Laden der gewünschten Web-Inhalte zu lange, wandern Kunden schnell zur Konkurrenz ab.

Phishing: Cyberkriminelle nutzen Web Scraping, um im Internet veröffentlichte E-Mail-Adressen abzugreifen und für Phishing zu nutzen. Darüber hinaus können Kriminelle eine täuschend echt aussehende Kopie der Original-Seite für Phishing-Aktivitäten nachbauen.

06

Rechtlicher Rahmen: Ist Screen Scraping legal?

Viele Formen des Web Scrapings sind vom Gesetz gedeckt. Dies gilt beispielsweise für Online-Portale, welche die Preise verschiedener Anbieter vergleichen. Ein entsprechendes Urteil des Bundesgerichtshofs aus dem Jahr 2014 stellt klar: Solange keine technische Schutzvorrichtung überwunden wird, die Screen Scraping verhindern soll, handelt es sich nicht um eine wettbewerbswidrige Behinderung.

Allerdings wird Web Scraping zum Problem, wenn es gegen das Urheberrecht verstößt. Wer urheberschutzfähige Texte ohne Quellenangabe in seine Website integriert, handelt also illegal.

Darüber hinaus ist bei einer missbräuchlichen Verwendung von Web Scraping beispielsweise für Phishing vielleicht nicht das Scraping an sich illegal, wohl aber die in der Folge durchgeführten Aktivitäten.

Häufige Fragen zu Web Scraping

Scraping (auch Web Scraping oder Screen Scraping) bezeichnet den manuellen oder automatisierten Vorgang des Extrahierens, Kopierens, Speicherns sowie der Wiederverwendung fremder Inhalte und Daten im Internet. Das automatisierte Auslesen von Informationen aus Webseiten bildet die Grundlage zahlreicher Webdienste wie Suchmaschinen oder Preisvergleichsportale.

Viele Formen des Screen Scraping sind vom Gesetz gedeckt, z.B. der Einsatz zur Website-Indexierung oder für Preisvergleiche. Neben diesem legalen und erwünschten Scraping gibt es aber auch illegale Formen, etwa wenn Angreifer urheberrechtlich geschützten Content unerlaubt kopieren und ohne Quellenangabe an anderer Stelle veröffentlichen (Content Grabbing).